Tarama bütçesi optimizasyonu (Crawl budget optimization), SEO kapsamında arama motoru botlarının bir internet sitesinde gerçekleştirdiği tarama yani crawling işleminin detaylarını görüntülemek ve arama motoru botlarının tarama eylemini daha verimli hale evriltmek amacıyla gerçekleştirilen optimizasyonlar bütünüdür. Temelde SEO kapsamında her zaman organik tıklama kazandırması beklenen sayfaların arama motoru botları tarafından daha sık taranması ve özellikle yeni sunulan sayfaların da hızlı bir şekilde taranarak indexlenmesi hedeflenir. İşte bu amaç doğrultusunda arama motoru botlarının sınırlı bir düzeyde olan tarama gücünü verimli kullanabilmek adına belli başlı kararlar ve tercihler alınarak optimizasyonlar yapılmalıdır. Hazırladığım bu içerikte, tarama bütçesi yönetimi ve tarama bütçesi optimizasyonu konusunda ipuçlarını paylaştım. Şimdiye kadar tüm arama motoru botlarını ifade eden bir tanım yapsam da, içeriğin devamında elbette Google arama motoruna ve Googlebot’a yönelik bir ifade kullanacağım.

İçindekiler

Googlebot Nasıl Çalışıyor?

Bilindiği üzere Google’ın interneti tarayan ve keşfettiği sayfaları gerçekleştirdiği tarama işlemi sonrasında -eğer dizine eklenmeye uygunsa- dizine ekleyen bir işleyişi bulunmakta. Google botları, internet ortamında farklı URL’leri ziyaret ederek keşfettiği tüm bağlantıları takip eder ve keşfedilen tüm sayfaları dizine ekleme amacı öncesindeki adımlar kapsamında işlemeye başlar. Keşfettiği sayfaları işleyerek sayfaların neyle ilgili olduğunu çeşitli teknolojilerle belirler ve sayfaları indeksleme öncesinde bir havuzda toplar. Devamında ise havuzda topladığı sayfaları yüzlerce SEO sıralama faktörü kapsamında filtreleyerek arama sonuçlarında uygun gördüğü sıralamalarda pozisyonlandırır.

Temel olarak bakarsak, Google’ın interneti tarayan ve internet sayfalarını arama sonuçlarında belli kurallara göre sıralandıran botları sırasıyla Keşfetme (Discovering), Tarama (Crawling), Dizine Ekleme (Indexing) ve Sıralama (Ranking) ana başlıklarında işlem gerçekleştirir ve Google arama motoru temelde bu yapıda çalışır.

Keşfetme (Discovering)

Herkese açık olarak yayınlanan ve internet dünyasına servis edilen bir URL’in Google botları tarafından fark edilmesi birçok faktöre bağlı olarak belli bir zaman alabilir. Google botları, bir URL’i keşfetmek için birden fazla kaynağı kullanır ve mümkün olduğunca yeni URL’leri hızlı bir şekilde keşfetmek ister. Google botları bir URL keşfetmek için site haritalarındaki bağlantıları, bir siteden başka bir siteye verilen bağlantıları, site içerisindeki dahili (iç) bağlantıları, sosyal medya platformlarında yapılan paylaşımları ve manuel olarak Google’a bağlantı gönderilmesi gibi kaynakları ve yöntemleri kullanır. Bu sayede bir URL’i keşfeder ve keşfettiği URL’leri tarama sırasına ekler.

Tarama (Crawling)

Google botları, yeni sayfaları keşfetmek veya mevcut sayfaları tekrar taramak için herhangi bir veri merkezi ya da ortak bir URL havuzu kullanmaz. Erişmesine izin olan internet sayfalarını belli aralıklarla sürekli olarak tarar ve burada bulduğu yeni iç ve dış tüm bağlantıları da takip edebilir. Ayrıca, taranan sayfalardaki içeriklerin de değişimini before – after olarak inceler ve sayfanın güncellenip güncellenmediğini de ölçümler.

En basit tabiriyle bir arama motoru olan Google, temel çalışma prensibi olarak internete yeni eklenen sayfaları keşfetmek ve listelemek için aralıksız olarak tüm interneti tarar. Kullanıcılara sunabileceği yeni sayfalar ve bilgiler tespit etmek için çabalar. Google botları, sayfaların taranmasıyla birlikte sayfa içeriklerini anlamlandırır ve taranan sayfanın ne ile ilgili olduğunu öğrenir. Tarama işlemi tamamlanan sayfalar, dizine ekleme aşaması için bir havuzda bekletilir.

Dizine Ekleme (Indexing)

Tarama aşaması sonrasında dizine ekleme öncesinde havuzda bekletilen sayfalar, Google arama sonuçlarında listelenmeden önce Google botları tarafından işlenir ve anlamlandırılarak sayfaların neyle ilgili olduğu çözümlenir. Sayfa içeriklerinde Google’a verilen tüm veriler (title, description, canonical, heading tags, Structured Data vb.) sayfa içeriğinin anlamlandırılmasında yardımcı olur ve Googlebot’a sınıflandırma ve segmentasyon açısından kolaylık sağlar.

Devamında da sayfalardan elde edilen anlamlı veriler, Google’ın veritabanlarına iletilir. Bu sayede taranan ve içeriği anlamlandırılan sayfalar, Google dizininde listelenmeye hazır konuma getirilir. Sayfaların işlenmesi sonrasında dizine eklemeyi engelleyen herhangi bir faktör olmadığı durumda da dizine ekleme gerçekleşir.

Sıralama (Ranking)

Yukarıdaki üç aşamada keşfedilen, taranan ve dizine ekleme öncesinde içeriği işlenen internet sayfaları, artık Google arama sonuçlarında pozisyonlanmaya ve kullanıcılara sunulmaya hazırdır. Google bu aşamada arama sonuçlarındaki sıralamaya etki eden yüzlerce sinyal kapsamında sayfaları değerlendirir ve süzgeçten geçirir.

Böylece kullanıcıların yaptığı aramalara en iyi yanıtı veren, en iyi kullanıcı deneyimi sunan ve en güvenilir sayfa(lar) tespit edilir ve arama sonuçlarında uygun sorgularda ve uygun pozisyonlarda listelenir.

Tarama Bütçesi (Crawl Budget) Nedir?

Tarama bütçesi, Googlebot’un günlük olarak bir internet sitesinin maksimum kaç sayfasını tarayabileceğini ve hangi sayfaları ne sıklıkta taraması gerektiğine karar vermesini ifade eden bir SEO terimidir. Tarama bütçesi, sayısı sabit şekilde belli olan bir miktar değildir ve birçok faktöre göre değişkenlik gösterebilen bir hacimdir.

Tarama Bütçesi Optimizasyonu Neden Yapılmalı?

Tarama bütçesi optimizasyonunda temel amaç, sayfalarımızı tarayan Google botlarını doğru sayfalara yönlendirmek ve önemsiz sayfalara yönelik tarama sıklıklarını mümkün olan en düşük seviyeye indirgemektir. Organik trafik potansiyeli sağlamayan, SEO stratejisinde bir anlamı olmayan ve içerik bakımından zayıf olan sayfaların tarama bütçesini tüketmesinin önüne geçmek için uygulanacak olan doğru bir tarama bütçesi optimizasyonu çalışması, SEO performansına ciddi oranda katkıda bulunabilir.

Temelde Google botlarını doğru yönlendirerek sitede taranması ve indekslenmesi istenen önemli sayfalara ulaşılabilirliğini rahatlatmak için tarama bütçesi optimize edilmelidir. Google botlarına kırık bağlantıların bulunduğu sayfaları, zayıf içeriğe sahip birçok URL’i, yönlendirmeli sayfaları, teknik anlamda çeşitli hatalar barındıran sayfaları ve açılış hızı çok düşük olan URL’leri sunmak iyi bir tercih değildir. Tarama bütçesinin kontrollü yönetilmemesi durumunda mevcuttaki önemli sayfalar yerine önemsiz olarak adlandırabileceğimiz sayfalar taranır ve indekslenir. Bu durumda da hem önemli varış sayfalarının hem de yeni açılan sayfaların taranma ve indekslenme sürelerinde ciddi gecikmeler ve aksaklıklar yaşanabilir.

Tarama Bütçesi Kontrolü Nasıl Yapılır?

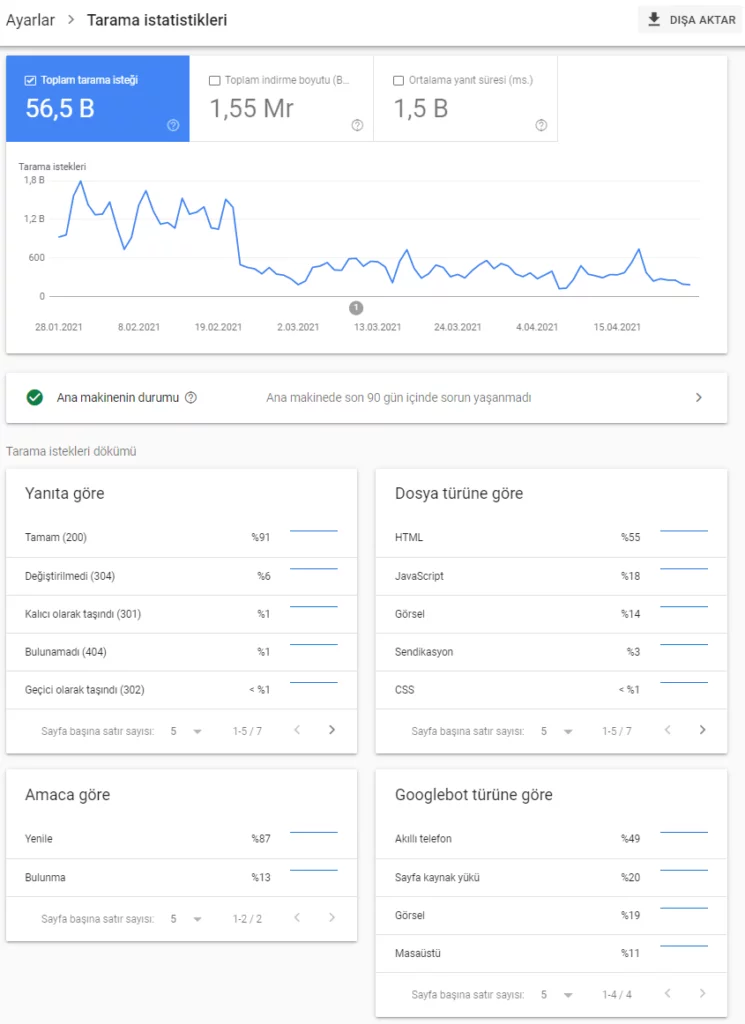

Güncel durumda tarama bütçenizin ne seviyede olduğunu, günlük kaç sayfanızın Googlebot tarafından tarandığını kontrol etmek için Search Console’daki Tarama İstatistikleri Raporu’nu kullanabilir ve buradan son 90 günlük tarama verilerinizi inceleyebilirsiniz. Google’ın internet siteniz için ayırdığı tarama gücünü ve eforunu kontrol etmek için aşağıdaki adımları uygulayabilirsiniz;

- Search Console mülkünüzde sol menüden Ayarlar‘ı açın.

- Ayarlar sayfasındaki Tarama İstatistikleri Raporu’na tıklayın.

- Karşınıza gelen ekranda “Toplam Tarama İsteği” grafiğini görebilir ve günlük bazda kaç sayfanızın tarandığını inceleyebilirsiniz.

Ayrıca aynı ekran üzerinde yer alan “Tarama istekleri dökümü” bölümünden de Googlebot’un ziyaret ettiği ve 200, 304, 404, 301, 302, 500 gibi yanıt aldığı sayfalarınızı inceleyebilir, buradaki sorunları gidermek için önemli ipuçları elde edebilirsiniz. Öte yandan Googlebot’un amacına göre “Yenileme” ve “Bulunma” seçeneklerini kullanarak URL’lerinizi inceleyebilirsiniz. Son olarak da “Googlebot’un Türüne Göre” alanından da mobil, masaüstü ve görsel Googlebot’ları ayrı ayrı ele alabilirsiniz.

Tarama Bütçesi Optimizasyonu Nasıl Yapılır?

Tarama bütçesi optimizasyonunda ve tarama bütçesi yönetiminde bireysel tercihlere ve sitenin kendi durumuna göre çeşitli değişkenler rol oynamaktadır. Bir sitenin tarama bütçesini etkileyen faktörlere genel olarak baktığımızda site hızı, site boyutu, içerik kalitesi, dahili bağlantı sağlığı, kopya içerik kullanımı, site içi bağlantı akışı ve site haritası ön plana çıkmaktadır. Bu değişkenler, sitenin günlük olarak kaç sayfasının Google botları tarafından taranacağına ve hangi sayfaların Googlebot tarafından ne sıklıkta ziyaret edileceğine etki eder.

Tarama bütçesi optimizasyonu kapsamında özellikle e-ticaret siteleri gibi URL sayısı yüksek olan sitelerde indekslenebilirlik tercihlerine göre bazı kararlar almak gerekebilir. Örneğin tarama bütçesi optimizasyonlarında genelde filtre sayfalarının Googlebot erişimine kapatıldığına ve taranmasının önüne geçildiğine rastlarız.

Fakat indekslenme tercihlerine göre örneğin bir Ayakkabı kategorisinde “42 Numara Siyah Spor Ayakkabı” filtresi bu tarama kısıtlamasından muaf tutulabilir ve indekse açılabilir. Buna benzer durumlarda indekslenebilirlik tercihlerine göre hareket etmek SEO performansını olumlu etkiler ve organik trafik artışı yaşanabilir.

1. Log Analizi (Log File Analysis) ile Googlebot Hareketlerini İncelemek

Bilindiği üzere sunucular, tuttuğu log (günlük) dosyaları ile birlikte sayfalara yapılan ziyaretlerin verisini tutar. User-agent bilgisi, IP adresi, ziyaret edilen sayfa, ziyaret tarihi ve saati gibi veriler log dosyalarında depolanır. Sunucuda yer alan log dosyasının analiz edilmesiyle birlikte Googlebot’un sitenizde hangi sayfaları ziyaret ettiğini, hangi sayfaları ne sıklıkla ziyaret ettiğini, hangi sayfadan hangi HTTP yanıt kodunu aldığını ve gün içerisinde kaç sayfa taradığını tespit edebilirsiniz.

Log analizi, tarama bütçesi optimizasyonunda önemli ipuçları elde edeceğiniz temel bir çalışmadır ve buradan elde edeceğiniz notlarla birlikte sitenizde taranabilirlik konusunda alacağınız aksiyonları belirleyebilirsiniz. Log analizi işlemi için Screaming Frog Log File Analyser ve SEMrush’ın Log File Analyzer araçlarını kullanabilirsiniz.

2. Sayfa Açılış Hızını İyileştirmek

SEO’da en önemli faktörlerden biri olan sayfa açılış hızı, tarama bütçesini de etkileyen değişkenler arasında yer almaktadır. Hızlı yanıt veren bir sunucuya ve hızlı bir şekilde oluşan sayfalara sahip olmak, site hızı için gerekli olan çalışmaları uygulamak ve özellikle Google’ın PageSpeed Insights aracının verdiği ve Search Console’daki Önemli Web Verileri Raporu’ndaki öneriler doğrultusunda optimizasyonlar yapmak sayfa açılış hızını olumlu etkiler. Sayfalarınızın hızında yaşanacak olumlu değişimler, genel veri tüketimini iyileştirerek Google botlarının daha az sürede daha fazla sayfayı taramasına olanak sağlar.

Yüksek kaynak dosyalarının yer aldığı bir sitenin yüklenme süresi de aynı orantıda artış gösterir ve sayfaların yüklenmesi gecikir. JS dosyaları, CSS dosyaları, görseller ve videolar boyutları itibarıyla bir sayfanın toplam kaynak boyutuna doğrudan etki eder. Artan sayfa kaynak boyutları, Google botlarının sayfayı tararken harcadığı süreyi, eforu ve indirdiği veri miktarını olumlu veya olumsuz olarak değiştirir.

Bu sebepten dolayı JS ve CSS dosyalarını optimize etmek, optimize edilmiş boyutlarda ve formatlarda olacak şekilde görseller ve videolar sunmak, tarama bütçesini optimize ederken sayfa açılış hızı kapsamında başvurabileceğiniz önemli aksiyonlardandır.

Öte yandan özellikle Core Web Vitals metrik değerlerini de ideal seviyelerde tutmak, sayfa açılış hızı optimizasyonu kapsamında SEO performansına olumlu katkısı bulunan bir diğer faktördür. Bu sebepten dolayı sayfalarınızın hızlı yüklenmesiyle birlikte hem tarama bütçesi hem de genel SEO performansı olumlu olarak etkilenecektir.

3. Mümkün Olduğu Kadar JavaScript İçerikten Kaçınmak & Statik HTML İçerik Sunmak

Google’ın JavaScript ile oluşturulan içerikleri tarayabildiğini biliyoruz. Fakat Google’ın JavaScript içerikleri her zaman sorunsuz bir şekilde tarayamadığını da biliyoruz. Her ne kadar Google mümkün olduğu kadar JavaScript içeriği tarayabilse de, bu işlem için ayırdığı maliyet ve efor sınırlıdır. Bu da tarama bütçenizi olumsuz etkileyebilecek bir faktördür.

Sayfalarınız eğer JavaScript içeriğe sahipse, bu sayfaların Google tarafından sorunsuz bir şekilde taranması ve dizine eklenmesi çok uzun sürebilir. Bu da özellikle önemli sayfalarınızın Google dizinine eklenmesini geciktirir ve organik trafik performansınıza zarar verebilir.

Tarama bütçesi optimizasyonu yaparken sayfalarınız için mümkün olduğu kadar JavaScript içerikten kaçınmalısınız ve içeriklerinizi statik HTML olarak sunmaya özen göstermelisiniz.

4. Kırık İç Bağlantıları & Dahili Yönlendirmeleri Kontrol Etmek

Site içerisinde sayfalar arasında verdiğiniz bağlantıların çalışır durumda olması ve 200 yanıt kodunu sağlaması, tarama bütçesi optimizasyonu için önemli başka bir maddedir. Site içerisinde çalışmayan iç linkler bulundurmak ve 404 olarak adlandırılan kırık linklere (broken links) sahip olmak, tarama bütçesini olumsuz etkiler. Google botları, bilindiği üzere bir sayfada gördüğü tüm bağlantıları takip eder ve tarama sırasına ekler. Bu sebepten dolayı site içerisinde çalışmayan veya silinen sayfaların bağlantılarını çalışan bağlantılarla değiştirerek tarama bütçenize katkıda bulunabilir ve daha sağlıklı bir tarama grafiği çizebilirsiniz.

İkinci olarak, tarama bütçesi yönetimi kapsamında Googlebot’un tarama kolaylığını sağlayabileceğiniz bir diğer etken de site içi yönlendirmeleri minimuma indirgemektir. Site içerisinde sayfalarınız arasında verdiğiniz iç bağlantılarınız doğrudan 200 versiyonuna değil de, arada bir veya birden fazla yönlendirme çevirerek 200 versiyonuna yönleniyorsa, bu durum 1 URL’in taranması için Googlebot’a 3-4 farklı yönlenen URL tarama yükünü verecektir. Bu durum da siteniz için ayrılan tarama miktarının gereksiz yere tüketilmesine sebep verebilir. Bu yüzden, site içerisindeki iç bağlantılarınızda mümkün olduğu kadar 301/302 iç yönlendirmelerden ve yönlendirme zincirlerinden (redirect chain) kaçınmalısınız.

5. Robots.txt Kurallarını Belirlemek

Sitenizi tarayan botların hangi dizinlere erişip erişemeyeceğini bildiren bir komut dosyası olan Robots.txt, tarama bütçesi optimizasyonunda aktif olarak kullanacağınız önemli bir kanaldır. Robots.txt dosyasına ekleyeceğiniz “Disallow” komutlarıyla birlikte Google botlarının hangi dizinleri, hangi URL’leri ve hangi parametreleri taramaması gerektiğini belirleyebilirsiniz.

Bu sayede SEO stratejinizde bir önemi olmayan URL’lerin taranmasının önüne geçebilir ve Google botlarını daha önemli olan sayfalarınıza yönlendirerek tarama bütçenizi optimize edebilirsiniz. Örneğin e-ticaret sitelerinde yer alan kategorilerdeki ürün sıralama filtreleri, arama sonuç sayfaları ve kategorilerdeki parametreli ürün filtrelerinin bu şekilde taranması engellenebilir.

Parametreli URL’lerin taranmasını engellemek için örnek Robots.txt kuralları;

User-agent: *

Disallow: *parametre1

Disallow: *parametre2

Disallow: *parametre3

6. Site İçi Bağlantı Akışını Yönetmek

Site içerisinde sayfalar arasında verilen bağlantılar Googlebot tarafından takip edilir ve taranır. Tarama bütçesi optimizasyonu kapsamında, SEO için bir anlam ifade etmeyen Sepet, Kullanıcı Sözleşmesi, Gizlilik Politikası, Profil sayfası vb. gibi sayfalar için site içerisinde verilen dahili bağlantılara eklenecek “nofollow” etiketi ile birlikte Google botlarının ilgili bağlantıları takip etmemesi sağlanır. Böylece A sayfasından Sepet sayfasına verilen bağlantı “nofollow” olduğu için Googlebot A sayfasından Sepet sayfasına gitmeyecek ve Sepet sayfasını taramayacak. Bu sayede Sepet sayfasına harcanacak tarama bütçesi başka bir noktaya kullanılmış olacak.

7. Kopya İçerikten Kaçınmak ve İçerik Kalitesini Artırmak

Site içerisinde yer alan içerikler, SEO performansına doğrudan katkıda bulunur ve kullanılan içeriğin kalitesine göre bu katkının katsayısı değişiklik gösterir. Aynı şekilde tarama bütçesi için de kaliteli içerik kullanımı yapmak, Googlebot’un sayfalarınızı daha fazla ziyaret etmesini sağlayacağı gibi kaliteli içeriğe sahip olan sayfalarınızın öncelikli şekilde taranmasına, içeriğinin daha iyi anlamlandırılmasına ve indekslenmesine yardımcı olur.

İçerik optimizasyonu yaparken duplicate olarak adlandırılan kopya içerikleri temizlemek ve birbirine içerik olarak çok benzeyen sayfalarınız için çeşitli SEO aksiyonları almak, hem sunduğunuz sayfaların içerik anlamında daha verimli ve faydalı olmasına hem de daha az URL ile daha güçlü bir SEO profiline sahip olmanıza yardımcı olur. Bu sayede bilgi dolu, zengin, birçok arama sorgusunun hedeflendiği ve Google’ın değer verebileceği şekilde içerik içeren sayfalara sahip olarak tarama bütçenize de katkıda bulunabilirsiniz.

8. Site Haritası Bağlantılarını Güncel Tutmak

Site haritalarında yer alan bağlantıların güncel kalması ve çalışır durumda olması, tarama bütçesi yönetiminde önemli bir noktadır. Site haritalarını düzenli bir periyotta okuyan Google botları, site haritalarında yer alan bağlantıları tarar ve daha önce dizine eklemediği URL’leri de keşfederek indeksler. Tarama bütçesi yönetimi için site haritalarında 404 bağlantıların yer almaması, 301/302 gibi yönlendirmeli URL’lerin bulunmaması ve taranması/indekslenmesi bilinçli olarak engellenen URL’lere yer verilmemesi gerekir. Site haritaları, bir internet sitesinde SEO performansı ve organik trafik kazanımı için önemli olan sayfaları mutlaka barındırmalıdır.

Site haritalarının içerisinde URL’leriniz için güncelleme tarihlerini sunmak da faydalı olabilecek faktörlerdendir. İçeriği güncellenen sayfalar için site haritalarınızda <lastmod> etiketini kullanabilirsiniz.

Site haritaları için örnek <lastmod> etiketi kullanımı;

<?xml version=”1.0″ encoding=”UTF-8″?>

<urlset xmlns=”http://www.sitemaps.org/schemas/sitemap/0.9″>

<url>

<loc>http://www.example.com/</loc>

<lastmod>2005-01-01</lastmod>

</url>

</urlset>

9. Site İçerisindeki Yetim (Orphan) Düzeyindeki Sayfaların Tespiti

Site içerisinde herhangi bir yerden bağlantı almayan ve bundan dolayı ulaşılabilir olmayan sayfalarınız yetim (orphan) olarak adlandırılır. Site içerisinde bu şekilde kayıp durumda olan sayfalarınızın Googlebot tarafından bulunabilir ve taranabilir olması açısından bu sayfaları tespit etmeniz ve sonrasında sitenizin menü, footer, sidebar, kategori, alt kategori veya ürün sayfaları gibi alanlardan linklerle bağlantısını sağlamanız, tarama bütçesi optimizasyonunda yapmanız gereken bir diğer önemli hamledir.

Bu sayede kullanıcıların site içerisinde menüden, kategorilerinizden veya alt kategorilerinizden hiçbir şekilde ulaşamayacağı sayfalarınızı daha görünür ve ulaşılabilir hale getireceksiniz. Beraberinde site içerisindeki bağlantı akışına dahil olacak olan yetim sayfalarınız, SEO performansı açısından da olumlu etkilenecek ve hem anahtar kelime pozisyonlarının iyileşmesinde hem de organik trafik rakamlarında performansınıza katkıda bulunacaktır.

Dijital Pazarlama Ajansı olarak, markanızın başarılı bir büyüme yolculuğuna çıkması için Boosmart’ın eşsiz pazarlama zekası çözümlerini sunuyoruz. İşletmenizin hedeflerini ve ihtiyaçlarını anlayarak, özelleştirilmiş pazarlama stratejileri oluşturmak için gelişmiş teknolojileri kullanıyoruz.

Boosmart’ın pazarlama zekası çözümleri, markanızın dijital varlığını optimize etmek, hedef kitlenizi daha iyi anlamak ve etkili bir şekilde pazarlama faaliyetlerinizi yönetmek için tasarlanmıştır. Sektördeki en son trendleri takip ediyor ve veri analitiği, yapay zeka ve otomasyon gibi güçlü araçları kullanarak markanızın büyümesini destekliyoruz.

YouTube kanalımıza abone olun;

https://www.youtube.com/c/boosmart

Instagram hesabımızı takip edin;

https://www.instagram.com/boosmartcom/

Telegram kanalımıza abone olun;